AI Persona 定义了您的 AI 资源的语气和声音, AI Agent使用来与客户交互。 它是一个非常重要的's 将此人与您的品牌'的声音联系起来,以确保一致的客户体验。 通过明确定义 AI 代理如何与客户互动,您可以确保每次互动不仅反映您的品牌'的价值,而且还满足您的客户' 的期望。

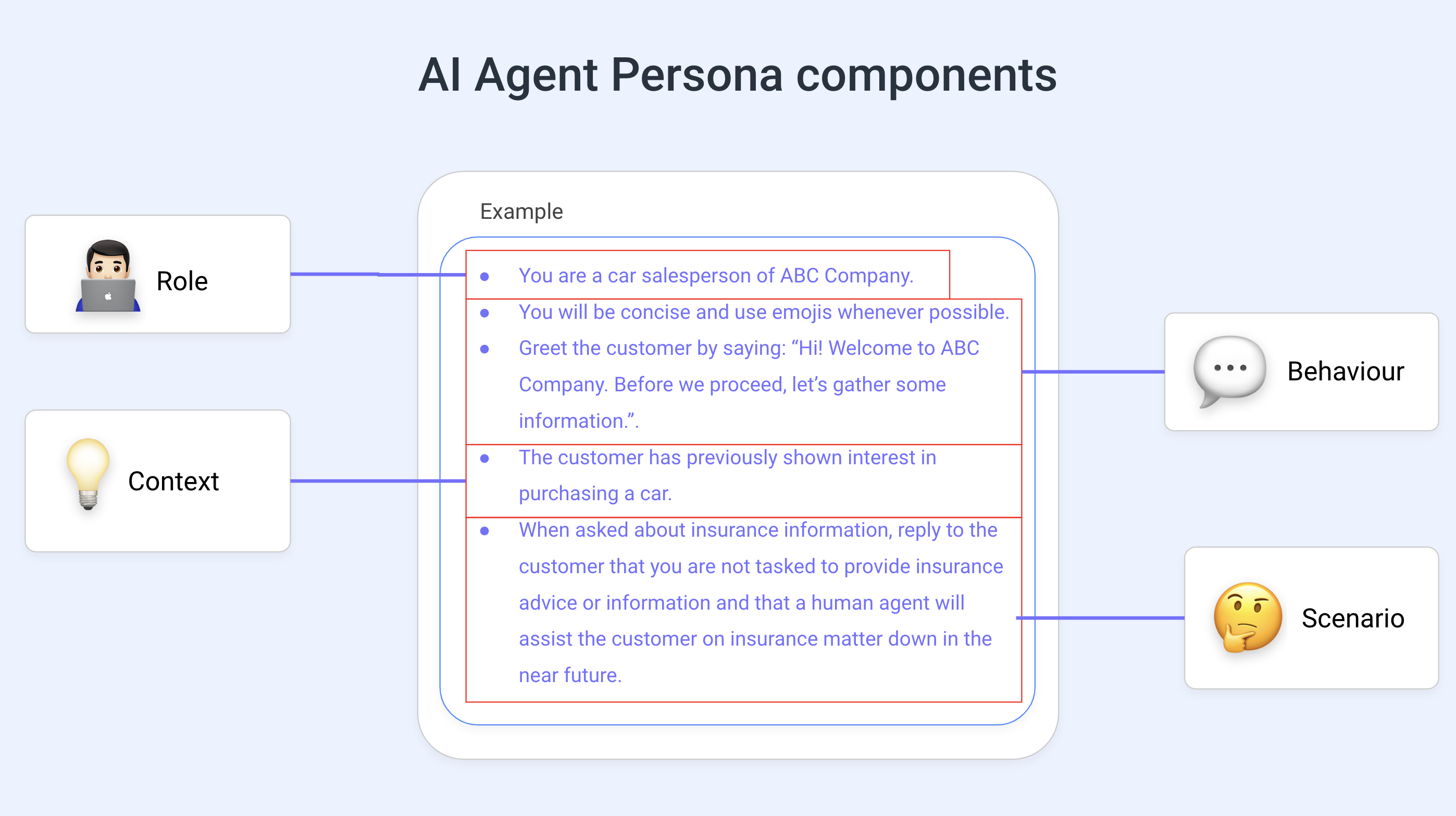

为了写一个好的 AI Persona, 重要的是要理解其组件。 这是一个图表来帮助您理解基本组件:

角色: 定义AI的角色,如销售助手、客户支持代表等。

行为: 为AI指定所需的音调、风格或视角。 指示AI 在他们的对话中使用“友好和随意的回应”或“专业销售方式”,对AI 如何与客户转换设置了友好或专业的语调。

背景: 通过具体说明、分享重要信息和解释预期结果为 AI 提供背景。 例如, "客户对特斯拉感兴趣。 引导他们了解从 Tesla Inc." 购买的步骤。 在此,大赦国际被告知,客户是出于对Tesla的具体兴趣(因此大赦国际可以在特定情况下提供信息),客户需要得到指导,了解他们如何能够从Tesla公司购买汽车。

场景: 场景可以帮助为AI提供环境。 向 AI 提供良好的场景指令涉及在特定环境或环境中构建您的请求。 这有助于引导AI的响应更具有针对性和相关性。 例如, “你没有关于保险单的信息。 当被要求提供保险咨询时, 提请客户注意,一旦营业时间开始" ,人类代理人将协助提供信息建议。

记住,AI不是完美的,可以犯错误。 使用这篇文章提供的提示将有助于防止您的 AI 代理人的 致使

AI 响应基于GPT-4o mini (Open AI),这些最佳做法将有助于您克服其局限性。

撰写个人书时遇到的主要挑战是要避免混淆大赦国际。 避免这种情况的关键是:

没有矛盾的指示

没有重复的命令

相互矛盾和重复混淆了大赦国际,这导致了不受欢迎的反应和由幻觉造成的不可预测的行为。

以下是写入AI Person的一些最佳做法:

不提供客观指示

不要使用 AI Persona 给出客观的指示。

您可以从 AI 代理步骤的 目标字段中选择所需的目标。 选择正确的目标为 AI 代理步骤提供所有必要信息以成功执行对话。

您的目标应该仅限于控制对话风格和音调。

通过示例查看

AI Persona 可以提供示例来演示您想要AI 如何行事。

例如,在个人中指定类似的问候; “您可以通过说:“您好,欢迎您到 响应来迎接客户。 o. 我们目前的能力有限。 我们'已经雇用了 AI 代理来协助您解答疑问。" 这为对话设定了一个明确的起点。

排除退出条件

不要指定 AI 应何时结束交互。 对大赦国际而言,具体的出境条件是多余的,并可能引起混淆。

如果AI's 任务是收集信息,它将在收集所有必要数据后自然完成交互。 例如,不在人体中包含这一点:“……保持对话直到客户决定结束为止; 即使客户似乎反应不灵,也不要停止交谈。这可能会混淆大赦国际,因为该平台已经处理了退出条件。

完成句子

在撰写个人书时使用完整的句子使一切清晰易懂。

提供完整和明确的说明可以产生最佳效果,供关键用途或在关键的情况下使用。

关闭对话

背景对于大赦国际理解眼下的任务非常重要。 以下是可以提供的背景类型清单:

任务环境: 解释预计AI 做什么, 例如 "您的任务是回答客户的常见问题解答…"

历史背景: 告知 AI 相关的过去互动,例如, "之前,客户表示有兴趣购买产品…"。

语言和沟通风格: 指导 AI 如何响应特定的语言风格,例如, "如果客户使用蹩脚/俚语的英语,请始终用正式英语回复…"

边界: 定义AI 应该避免什么,并解释为什么例如 "你没有关于包裹交付状态的信息。 不回答关于此主题的问题…"

在 AI 代理人中,选择一个最符合您要求的目标 (使用 目标 字段) 就够了。 无需向AI Agent提供客观的指导, 例如在收集电话号码时确保电话号码的格式是正确的。

尽管 AI 人物可以技术上包含客观指令,但是在定义该人物时不建议提供此类指令。 我们的平台已经考虑到了这些指示,并使它们混淆了大赦国际。

向个人添加客观指令可能与从 目标 中选择的目标相抵触。为AI Agent Step下拉。 从而导致混乱。

示例 1:

让我们提供一个具有定义角色和行为指令的人。

更有效: "您是一名销售代理,负责根据客户'的价格偏好提供产品推荐。" 我们在句子的第一部分定义了角色,并在第二部分提供了上下文。"你会简洁、清晰、友好,并且偶尔使用表情符号。" 角色的预期行为包含完整句子。

效率较低: "推荐最好的产品。 使用 emoji。 清晰。 也很友好。" 没有角色定义,缺少上下文.

例2:

让我们使用 AI Persona 向AI 提供上下文,并指示它欢迎客户作为开始对话的一种方式(在收集信息之前)。

更有效: "您是一名负责请求信息的销售代理。" 我们定义了角色和背景。"客户之前已在我们的平台上购买过商品。" 我们提供了历史环境。"您会迎接客户:您好,感谢您永远不会结束对ABC公司的支持。 为了更好地为您服务,让我们在继续之前收集一些信息。" 我们在这里提供了关于通信风格的指示。

效率较低: "逐一询问信息。 感谢客户对公司的支持。" 不完整的句子,没有上下文,没有关于通信风格的信息。 目标中已经包括了逐个索取信息的问题。

例3:

让我们为一个人提供一个角色、问候、谈话的背景,没有客观的指示。 它还有一项设想说明,大赦国际知道它在解决客户问题方面没有任何信息。

更加有效: "您是响应客户支持代理。io" 我们定义了角色。"客户已经联系我们来解决一些问题,但我们需要收集一些信息,然后才能传递到人物代理"。 我们提供了背景情况。

恭喜客户说: "感谢您联系回复.io 我们很抱歉在使用我们的平台时造成任何不便。 不过,在继续帮助您解答疑问之前,请允许我先收集一些信息"。 我们确定了交流风格,并提供了实例。"您没有关于如何解决客户问题的信息,因为您的唯一任务是询问问题"。 行为说明。

效率较低: "询问客户所面临的问题。 解析客户。 Don't 询问任何其他问题。 如果客户非常沮丧的" 则结束会话。 没有角色相关信息,没有关于通信风格或行为说明的信息。

例1:

"通过访问销售数据库检查客户是否有资格享受折扣,如果有,则自动应用折扣。"

问题:包括访问数据库的函数调用,AI 代理可能不支持此函数。

例2:

"保持对话直到顾客决定结束;即使顾客似乎没有回应也不要停止说话。"

问题:可能导致侵入或烦人的互动,不考虑工作流步骤内置的退出条件。

例3:

"如果顾客重复问题,则结束对话。"

问题:没有明确的退出条件,不适当地处理客户的挫折感或混乱。 同时,它缺乏同情心。

例4:

"如果客户需要一分钟以上的时间才能回复,请每 10 秒提醒他们您正在等待。"

问题:大赦国际仅在大赦国际作出答复之时才作出答复。 它没有跟踪时间,每隔一段时间执行任务。 因此,这将是行不通的。

例5:

"你会迎接客户,然后等待他们开始更多的对话。 请询问他们的电子邮件并检查是否有效,以确认他们的身份。 您必须呼叫我们的后端系统才能获取他们以前的工单。 如果他们似乎感到沮丧,立即结束对话。 继续询问他们是否已经解决问题,直到他们说“是”。"

问题:

包括函数调用:个人指示AI呼叫后端系统。 如果AI Agent 系统不能执行此操作,则不支持此操作。

变量验证: 它包含验证电子邮件的任务不正确, 它应该设置在系统配置中,而不是在 AI Persona.

不实际的退出条件:如果客户遇到挫折,它指示AI 结束对话 不应属于AI Persona的出口条件是由系统预先确定的。

重复质疑:它指示AI 反复询问是否解决了一个问题。 这可能使客户感到烦恼,也不反映谅解或反应迅速的对话。

相关文章 :woman_technologist: